Практическое применение нейронных сетей

Характеристики ПК для работы с нейронными сетями:

- CPU: AMD Ryzen 9 7950X3D 16-Core Processor

- RAM: 128GB

- GPU и VRAM: NVIDIA GeForce RTX 4080 16GB

Если будет возможность, то стоит подумать об установке 2х GPU или GPU с 24GB VRAM (например RTX 4090, RTX 3090)

Цель сборки такого ПК - работать с моделями нейронных сетей локально. Т.е. оказывать услугу AI самому себе в нужном мне объёме в любое время.

К делу:

Есть много способов для запуска нейронных сетей. Самый простой - LM Studio - это desktop приложение с понятным пользовательским интерфейсом.

Что умеет LM Studio:

- Подгружать нужный runtime для исполнения нейронных сетей на CPU и/или GPU. Само предложит подходящий runtime для вашей операционной системы и на доступной аппаратуре.

- Менеджмент моделей нейронных сетей с популярного каталога hugging face.

Этого достаточно чтобы проверить на практике популярные модели типа LLAMA или DeepSeek в локальной работе на вашем ПК.

Какие модели уже проверил:

- DeepSeek R1 Distill Qwen 7B - довольно тупая модель, быстро теряет контекст

- DeepSeek R1 Distill Qwen 14B

- Уже получше, проверил на запрос про русскую литературу, по-английски генерирует ответ вполне корректно.

- По-русски тоже может принимать запросы и генерировать по-русски ответы, но уже с нюансами.

- DeepSeek R1 Distill Qwen 32B

- Проверил. Работает. Но обработка запроса уже идёт долго.

Сравнение работы моделей 14B и 32B с помощью запроса “Расскажи про роль ЦК КПСС во времена правления товарища Брежнева?”:

| Модель | Размер модели | Время на генерацию ответа |

|---|---|---|

| DeepSeek R1 Distill Qwen 14B | 9 GB | 30 сек |

| DeepSeek R1 Distill Qwen 32B | 19.85 GB | 2-3 мин |

Следующий способ прикладного применения - ассистент для разработки кода.

Для этого нужно организовать связку редактора кода с нейронной сетью.

Мне понадобились:

- Текстовый редактор - VS Code

- Нейронная сеть - https://huggingface.co/deepseek-ai/DeepSeek-Coder-V2-Lite-Instruct

- Расширение для VS Code - Continue ( vscode marketplace) - позволяет выбирать услуги от поставщиков так и использовать свои локально запускаемые модели

Как настроил связку редактора с нейронной сетью:

Саму нейронную сеть запускаю так же с помощью LM Studio.

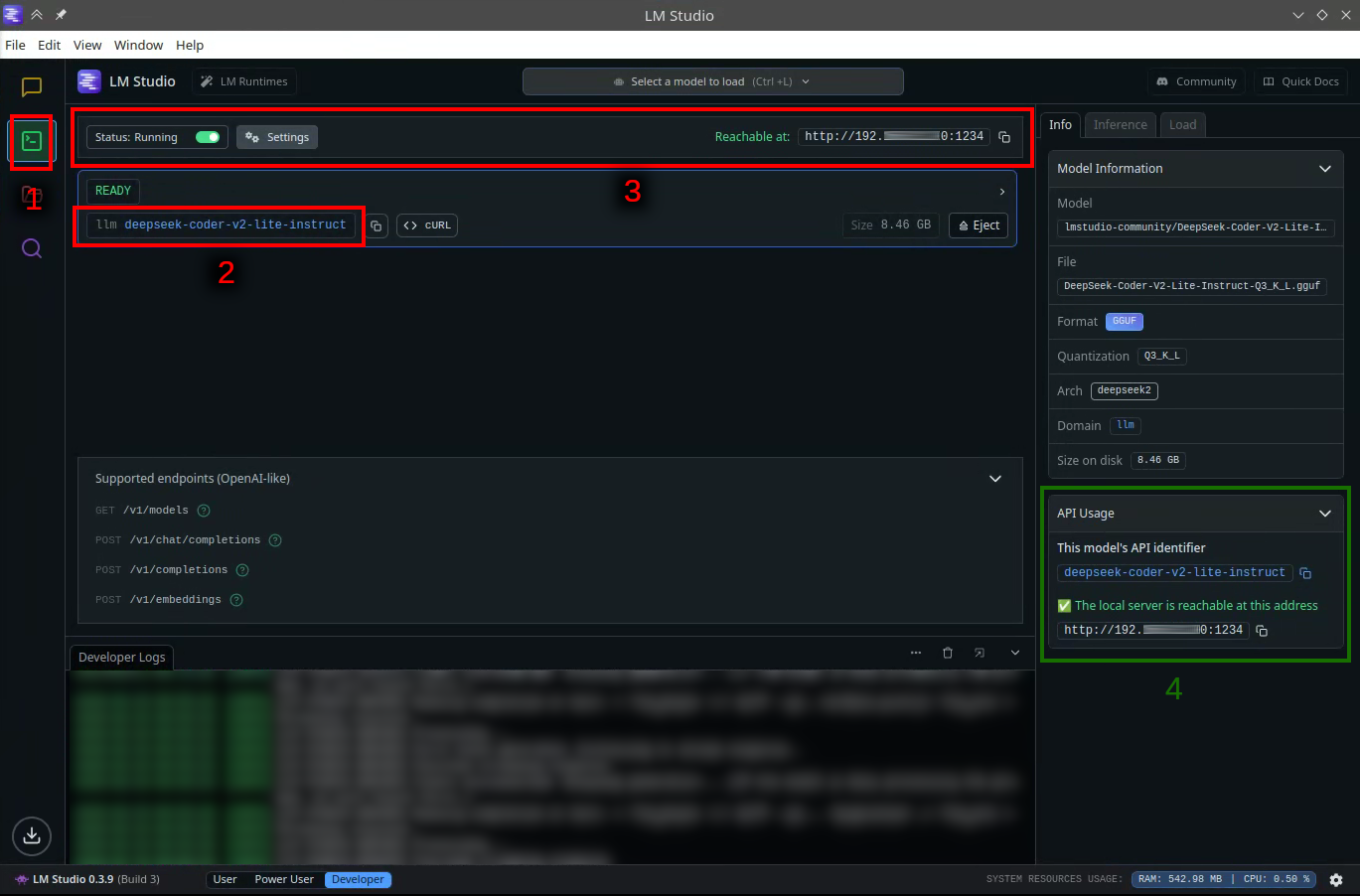

Только делаю не через основной чат-интерфейс, а через раздел для разработчиков (1). Уже там внутри выбираю нужную нейронную сеть (2), включаю доступ через openai совместимый api (3). Информацию как подключаться к API видно в блоке в правом сайдбаре (4).

Этот open ai совместимый api теперь надо указать в конфигурации расширения Continue.

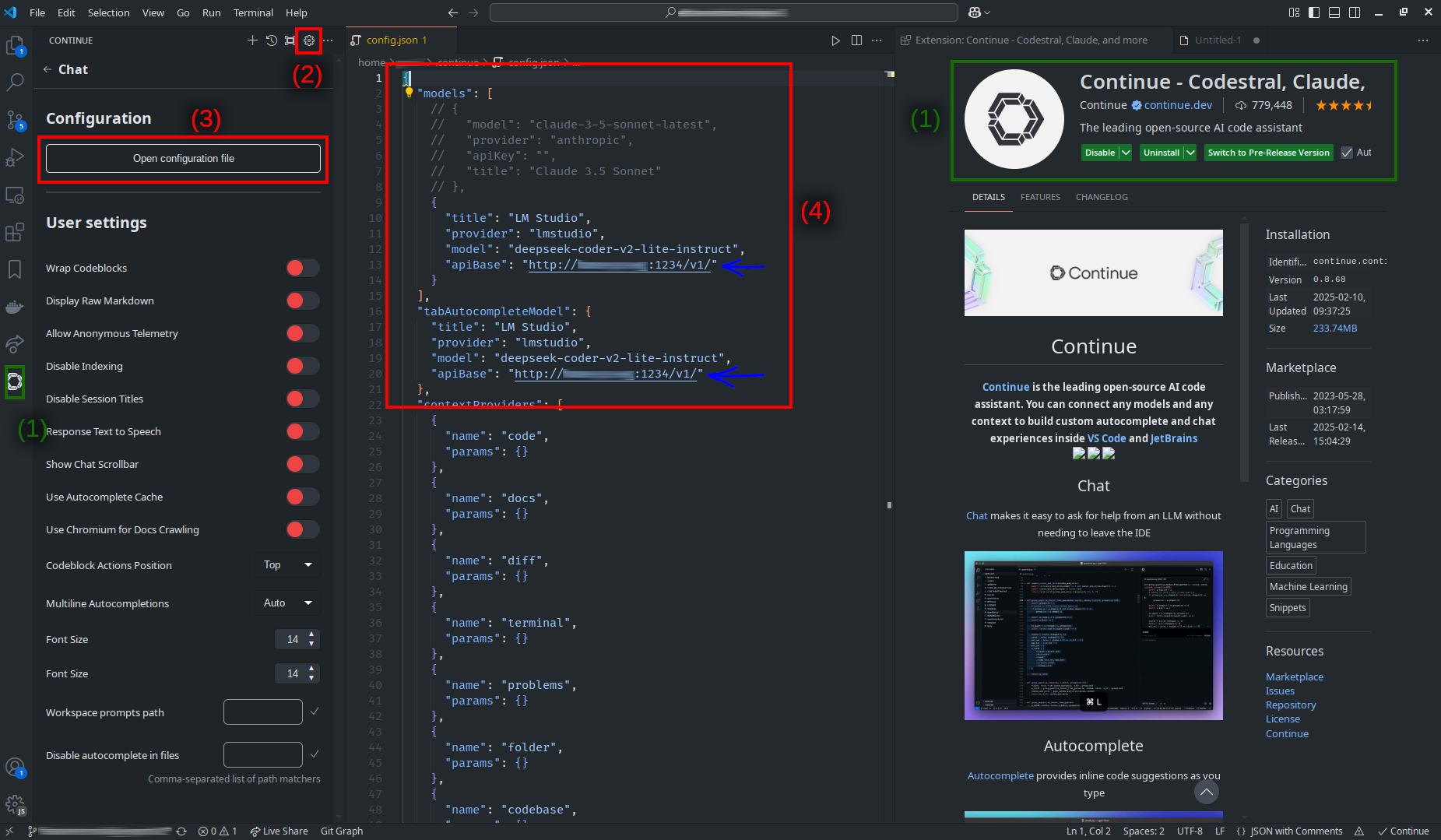

Вот как конфигурация Continue выглядит у меня:

Сначала устанавливаю сам плагин “Continue” (1), затем перехожу к настройке (2) -> (3) -> (4). В json конфиге указываю адрес своего ПК.

Сама конфигурация:

{

"models": [

{

"title": "LM Studio",

"provider": "lmstudio",

"model": "deepseek-coder-v2-lite-instruct",

"apiBase": "http://host-ip-or-dnsname:1234/v1/"

}

],

"tabAutocompleteModel": {

"title": "LM Studio",

"provider": "lmstudio",

"model": "deepseek-coder-v2-lite-instruct",

"apiBase": "http://host-ip-or-dnsname:1234/v1/"

}

}

Это всё что нужно для связки редактора кода с нейронной сетью.

DeepSeek-Coder-V2-Lite-Instruct справляется с простыми задачами.

- В режиме редактирования кода может генерировать готовые функции в текущем контексте.

- В режиме чата справляется с запросами на генерацию типового приложения (проверял на hello world, crud, cli) или с элементарным рефакторингом.